萧箫 发自 凹非寺

量子位 | 公众号 QbitAI

还记得大牛们就“AI是否可能灭绝人类”,分成了两大阵营吗?

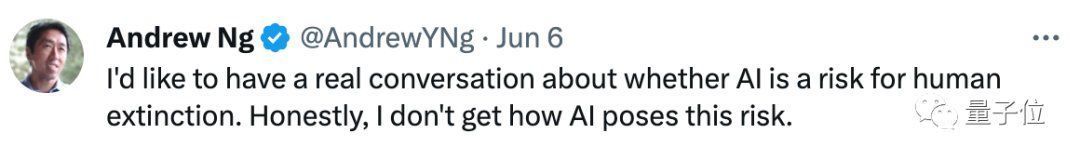

由于并不理解为啥“AI会造成风险”,吴恩达近开启了一个对话系列,去找两名图灵奖得主聊聊:

AI究竟存在哪些风险?

有意思的是,在相继和Yoshua Bengio以及Geoffrey Hinton进行深度对话后,他和他们“达成了不少共识”!

他们一致认为,双方应该共同讨论AI具体会产生什么风险,以及它究竟“理解了什么”。Hinton还特意cue了“反方代表”图灵奖得主Yann LeCun:

学术界在这个问题上分歧太大了,包括我们非常尊重的学者如Yann,就认为大模型并不理解它自己在说什么。

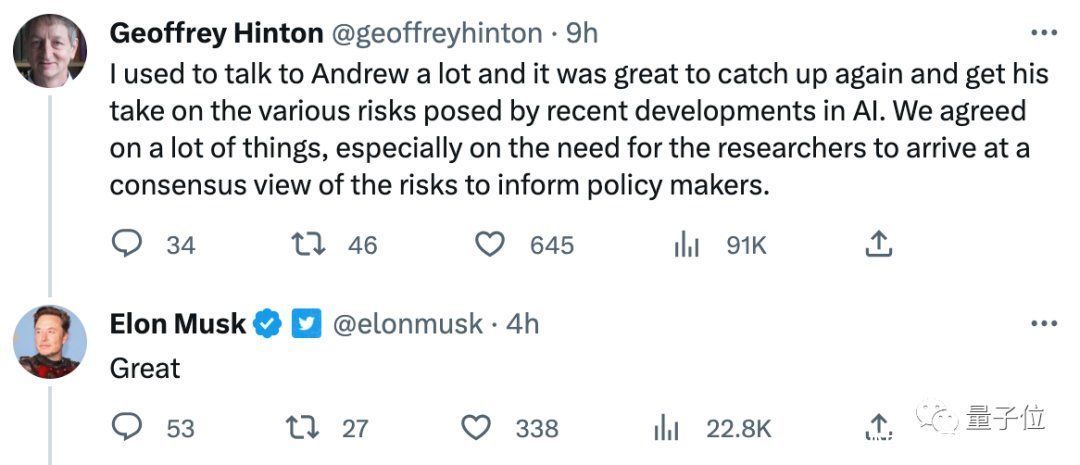

马斯克对这次谈话也很感兴趣:

除此之外,Hinton近还在智源大会上再一次“布道”AI风险,表示比人更聪明的超级智能很快就会出现:

我们不习惯思考比我们聪明得多的东西,以及如何与它们互动。

我现在看不出如何防止超级智能“失控”,而我已经老了。我希望,更多年轻的研究人员能掌握控制超级智能的方法。

一起来看看这些对话的核心观点,以及不同AI大牛针对这件事的看法。

吴恩达对话图灵奖得主:AI安全应达成共识

首先是与Bengio的对话。吴恩达和他达成了一个关键共识,即:

科学家们应该试着找出“AI风险存在的具体场景”。

也就是说,AI究竟会在哪些场景下,给人类带来重大危害、甚至导致人类灭绝,这是双方需要达成的共识。

Bengio认为,AI前景充满着“迷雾和不确定性”,因此找出一些AI具体带来危害的场景是有必要的。

然后是与Hinton的对话,双方达成了两个关键共识。

一方面,所有科学家必须针对“AI风险”议题好好聊聊,以便于制定良好的;

另一方面,AI确实在理解世界。科学家们需要列出其中的关键技术问题,这有助于在AI安全议题上达成共识。

在这个过程中,Hinton提到了需要达成共识的关键点,即“GPT-4和Bard这类对话大模型是否真的理解它们自己在说什么”:

有些人认为它们理解,有些人认为它们只是随机鹦鹉。

我想我们都相信它们理解(自己在说什么),但一些我们非常尊重的学者如Yann,则认为它们并不理解。

当然,被“喊话”的LeCun也及时赶来,很认真地发表了自己的观点:

我们都同意“大家需要就一些问题达成共识”这件事。我也同意Hinton的观点,即LLM有一定的理解能力,说它们“只是统计数据”是误导性的。

1、但它们对世界的理解非常肤浅,很大程度上是因为它们仅仅用纯文本训练。从视觉中学习世界如何运作的AI系统,将对现实有更深入的理解,相比之下自回归LLM的推理和规划能力非常有限。

2、如果没有下述条件,我不太相信会出现接近人类(甚至是猫)水平的AI:

(1)从视频等感官输入中学习的世界模型

(2)一个可以推理和规划(而不仅仅是自回归)的架构

3、如果我们有了懂得规划的架构,它们将是目标驱动的,即能基于优化推理时间(而不仅仅是训练时间)目标来规划工作。这些目标可以是让AI系统“听话”且安全的护栏,甚至终打造出比人类更好的世界模型。

然后,问题就变成了设计(或训练)保证安全和效率的良好目标函数。

4、这是一个困难的工程问题,但没有一些人所说的那么难。

虽然这一段回应仍旧只字未提“AI风险”,不过LeCun很实在地给出了提升AI安全性的建议(打造AI“护栏”),并设想了比人类更厉害的AI“长啥样”(多感官输入+可推理规划)。

某种程度上来说,也算是双方在AI存在安全问题这个观点上达成了一些共识。

Hinton:超级智能比想象中更近

当然,不止是和吴恩达的对话。

近离职谷歌的Hinton,在不少场合都谈到了AI风险这一话题,其中也包括近参加的智源大会。

在大会上,他以《通往智能的两条路线》为主题,讨论了“知识蒸馏”和“权重共享”两种智能路线,以及如何让AI变得更智能,以及自己对于超级智能出现的看法。

简单来说,Hinton不仅认为(比人更智能的)超级智能会出现,而且出现的时间比人们想象中更快。

不仅如此,他认为这些超级智能会失控,但目前他还想不到什么好的方法阻止它们:

超级智能可以通过操纵人来轻易获得更多权力。我们不习惯思考比我们聪明得多的东西,以及如何与它们互动。但它会变得善于欺骗人,因为它能通过某些小说作品中学习欺骗他人的案例。

一旦它变得善于欺骗人,就能掌握让人们做任何事的方法……我觉得这很可怕,但我看不出如何防止这种情况发生,因为我老了。

我希望,像你们这样的年轻有才华的研究人员,会搞懂我们如何拥有这些超级智能,并让我们生活得更好。

放映出“THE END”幻灯片时,Hinton意味深长地强调了一下:

这是我的后一张PPT,也是这场演讲的结束。

参考链接:

[1]https://twitter.com/AndrewYNg/status/1667920020587020290

[2]https://twitter.com/AndrewYNg/status/166658217*7254402

[3]https://2023.baai.ac.cn/

— 完 —

量子位 QbitAI · 头条号签约

2. 分享目的仅供大家学习和交流,您必须在下载后24小时内删除!

3. 不得使用于非法商业用途,不得违反国家法律。否则后果自负!

4. 本站提供的源码、模板、插件等等其他资源,都不包含技术服务请大家谅解!

5. 如有链接无法下载、失效或广告,请联系管理员处理!

6. 本站资源售价只是赞助,收取费用仅维持本站的日常运营所需!

7. 如有侵权麻烦联系邮箱2697381891@qq.com删除文章!

源码库 » 图灵奖得主Hinton:我已经老了,控制比人类更聪明的AI交给你们了